Александр Соколов. Сергей, спасибо. Следующий вопрос, который будет адресован Татьяне, будет задавать система искусственного интеллекта GPT-3. Я попрошу сейчас включить систему искусственного интеллекта.

Система ИИ GPT-3. Насколько необходима или желательна разработка искусственного интеллекта, предназначенного исключительно для боевых действий?

Татьяна Шаврина. Есть большое опасение, что когда мы достигнем уже определенных успехов в моделировании более простых задач, про это узнают военные и захотят делать манхэттенский проект с искусственным интеллектом. Если бы он существовал уже сейчас, мы бы что-то про это как-то узнали. Вроде бы, не существует.

Александр Соколов. Скрывают.

Татьяна Шаврина. Видите, уже сам искусственный интеллект интересуется, уже опасно.

Источник: https://interesnyefakty.org/innokentij-smoktunovskij

Александр Соколов. Сейчас будет второй вопрос от искусственного интеллекта в образе Иннокентия Смоктуновского.

Система ИИ GPT-3. Сможет ли искусственный интеллект корректно воспринимать и оценивать степень опасности людей?

Александр Соколов. Вопрос к Сергею.

Сергей Марков. Это очень хороший вопрос. Он позволяет немножко отойти от нашей антропоцентрической позиции. Мы очень часто предъявляем определенные требования к системам искусственного интеллекта. Встает большой вопрос: насколько мы сами соответствуем тем требованиям, которые предъявляются? Когда некоторые алармисты говорят о возможной опасности поручения системам искусственного интеллекта контроля над сложными процессами и технологиями, при этом считается, что оставить контроль над этими технологиями за человеком – это безопасно. По мере технологического прогресса себестоимость апокалипсиса стремительно падает. Я думаю, что здесь вопрос с подвохом. Важно понимать, что в определенной ситуации люди сами не соответствуют тем высоким требованиям, которые мы предъявляем к тестируемым нами системам. Автопилот в автомобиле мы можем исследовать, заставив его накатать миллионы километров вначале в виртуальной среде, потом в ходе каких-то тестов. Когда мы садимся в такси, то мы предварительно не подвергали водителя столь же жесткому контролю, масштабному испытанию. Почему человек доверяет другому человеку, которого он видит первый раз, и не доверяет системам, которые были созданы в результате прямого инжиниринга и многократно протестированы в специальных экспериментах?

Александр Соколов. Спасибо, Сергей. Сейчас вопрос от нашего постоянного зрителя «Пирожка с ковидлом»: насколько реально воспроизвести творческие способности, используя генератор случайных чисел и последующий анализ результатов? Татьяна, что вы скажете?

Татьяна Шаврина. Не знаю, при чем тут генератор случайных чисел. Мне нравится в задачах искусственного интеллекта то, что они ставят перед нами такие задачи, которые нам позволяют не только что-то построить, но и узнать чуть больше про себя. В этом плане задача искусства очень интересная. Это насущный вопрос задач эволюционной психологии. Что вообще человеку кажется красивым? Чтобы формулизовать то, что нам кажется красивым, надо поставить много экспериментов и выяснить. Тогда машина сможет это как-то воспроизводить. Сейчас у нас есть уже системы, которые могут генерировать картины, музыку. Это кажется достаточно симпатичным. Сказать, что это творчество, наверное, в какой-то момент можно будет, если там будет действительно целеполагание. Если мы научимся осмысленно нарушать канон и при этом считать, что это все равно красиво. Тогда сможем.

Александр Соколов. Спасибо. Вопрос Дениса из Москвы, адресованный Сергею: в какую сторону смотреть разработчику, который хочет научиться программно работать с человеческой речью?

Источник: https://online47.ru/2019/11/22

Сергей Марков. Последние несколько лет, даже десятилетий большой прогресс в этой области связан с развитием нейросетевых моделей. Я бы посоветовал читать отдельные научные публикации. Можно зайти на сайт paperswithcode.com. По каждой интересующей вас задаче (распознавание речи, синтез речи), там есть лидерборды. Можно посмотреть лучшее решение, которое существует в этой области. Обычно там есть научная статья создателей этой системы, можно ее почитать и узнать о тех алгоритмах, нейросетевых архитектурах, которые лежат в основе этой системы. Еще в большинстве случаев можно посмотреть реальные примеры реализации в виде кода на GitHub.com. Наверное, сегодня это самый правильный способ изучения передового края технологии. Систематическая литература, книги не успевают за той скоростью прогресса, которую мы наблюдаем. Если вы почитаете книгу даже хороших авторов, она будет в какой-то мере вам рассказывать о состоянии технологий 2-3-летней давности.

Александр Соколов. Спасибо. Вопрос для Татьяны от Юрия Феденева из Москвы: как вы считаете, существует ли возможность использовать искусственный интеллект в управлении или частичном управлении опасным производством – АЭС, ГЭС и так далее? Высока вероятность человеческого фактора при выполнении операций.

Татьяна Шаврина. Я думаю, что это очень хорошее направление для автоматизации труда. Как раз это можно свести к задаче оптимизации. Сейчас современные системы искусственного интеллекта используются на опасных производствах и не только на опасных, чтобы предсказывать износ оборудования. Это сейчас предсказывается очень хорошо и снижает аварийность.

Александр Соколов. Спасибо. Вопрос для Татьяны от Латы из Нижнего Новгорода: для работы с человеком обязательно ли внедрять ИИ человеческие эмоции для комфорта работы с ИИ?

Татьяна Шаврина. Это интересный вопрос. Мне кажется, что он как раз очень плотно связан с тем, что мы считаем хорошим решением, а что – не очень от ИИ. Когда мы говорим о том, что мы будем внедрять искусственный интеллект в управление проектами, в автоматизацию решений, в госуправление, то мы уже ждем, что мы будем получать ответы, не просто которые будут нас устраивать по качеству, но и которые мы будем понимать. Эмоциональная составляющая здесь участвует, она способствует этому пониманию. Эмоциональную составляющую включить можно уже сейчас, это не является технологической преградой. Технологической преградой является нормальное обоснование решений. Здесь прогресс запаздывает. Может быть, он опоздает очень сильно.

Источник: https://hi-news.ru/technolog

Даже если мы сможем обучать модели, принимающие самые мультимодальные данные (картинки, видео, текст), и обрабатывающие их, даже если будет среда, в которой модель будет обучаться и понимать, что лучше, что хуже, она все равно не научится нам это передавать. Сейчас запаздывают системы интерпретации результатов. Мы можем из сетки как-то получить, что она увидела корреляцию. Иногда нужно сделать очень много шагов, чтобы понять, что эта корреляция была ложная. Модуля перепроверки этих данных нет.

Мы знаем эту фундаментальную проблему – корреляция не означает причинно-следственную связь. Уровень преступности в Нью-Йорке коррелирует с потреблением мороженого в Нью-Йорке. Долго думали, почему. Просто оба фактора коррелируют еще со средней температурой. Летом повышается и уровень преступности, и уровень потребления мороженого. Это все у нас сохраняется в искусственном интеллекте. Он даже может вынести решение, как-то даже его перепроверить. Потом мы спросим: почему? А у нас модуль логики не подключен к модулю языка, мы не можем сказать.

Александр Соколов. В этом случае две функции не являются независимыми, поэтому корреляцию строить неправильно между ними.

Татьяна Шаврина. Это как мы запрограммируем.

Александр Соколов. Вопрос от Александра Багмы: как вы считаете, возможно ли построение сильного ИИ, как мультиагентной системы? Используются ли идеи, изложенные Марвином Ли Минским в таких книгах, как «Сообщество разума» и «Машина эмоций» в неакадемических поректах? Я не читал этих книг. Сергей, вы читали?

Источник: https://m.readly.ru/author/5883/

Сергей Марков. Да, конечно. Марвин Ли Минский – это один из классиков искусственного интеллекта, довольно интересным образом повлиявший на развитие коннекционизма, нейронных сетей. С одной стороны, он был одним из пионеров этого направления.

Еще в начале пятидесятых годов он создал первую систему, управляемую искусственной нейронной сетью. С другой стороны, считается, что он внес свой вклад в критику работ Фрэнка Розенблатта. В какой-то мере это повлияло на наступление зимы искусственного интеллекта в семидесятые годы. Сейчас активно изучаются различные мультиагентные системы. Такая большая сфера машинообучения, как обучение с подкреплением, является бурноразвивающимся направлением.

Есть место и мультиагентным системам. Создание систем универсального искусственного интеллекта, режимы их обучения вполне себе могут быть связаны с таким обучением мультиагентных средах. Мы коротко затронули проблему сознания, будет оно или не будет у систем искусственного интеллекта. Моя научная позиция заключается в том, что сознание в какой-то мере является продуктом как раз мультиагентных взаимодействий. Появление эусоциальности привело к необходимости появления модели другого для того, чтобы прогнозировать поведение других агентов. Дальше эта модель была применена к самому субъекту. Появилась галерея зеркал отражения человеческим сознанием себя самого. Это направление активно развивается, является одним из мейнстримов в области работы над универсальным искусственным интеллектом.

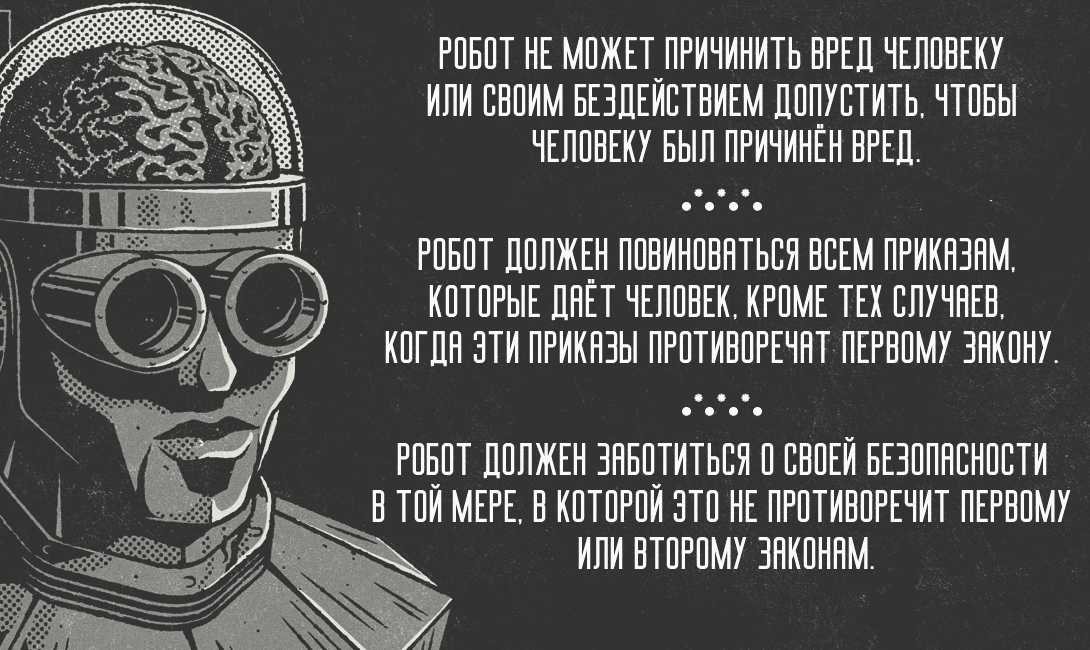

Александр Соколов. Спасибо. Вопрос от Андрея Савченко: в далеком будущем научному сообществу удалось создать сопоставимый с человеческим ИИ. На его основе создаются автономные роботы для решения различных задач. Как вы думаете, будут ли достаточны по своей сути три закона робототехники в качестве основного защитного механизма в подобных системах? Если нет, то что бы предложили вы, Татьяна?

Татьяна Шаврина. Я думаю, что тут Сергей даже лучше меня прокомментирует. Мне кажется, что рассуждая о таком далеком будущем, скорее всего, у нас будет какой-то другой способ инкорпорировать необходимые нам знания в искусственный интеллект. Необязательно будут просто строгие запреты и правила робототехники. Возможно, что это все равно останется. Мы сейчас разговариваем про искусственный интеллект, но обычно в индустрии очень часто все задачи решаются очень просто: написали пару правил и сказали, что у нас уже искусственный интеллект используется. Возможно, это тоже останется.

Александр Соколов. Что добавите, Сергей?

Сергей Марков. Все творчество Айзека Азимова посвящено тому, что трех законов робототехники недостаточно. Возникает множество парадоксов при использовании такой простой системы. Я думаю, что здесь системы и правила примерно так же годны к решению этой задачи, как Уголовный кодекс подходит для того, чтобы контролировать поведение людей. Это в принципе работает, но есть нюансы. Есть ситуации, когда оказывается, что даже такого сложного поведенческого кодекса недостаточно для того, чтобы здесь решить все проблемы.

Источник: https://brodude.ru/robot-kotoryj-vozmet-gryaznuyu-rabotu-na-sebya

Я думаю, что здесь направление развития будет связано с тем, что вряд ли мы будем так массово создавать универсальные системы искусственного интеллекта. Я думаю, что человечество пойдет по пути интеграции своего собственного интеллекта с продуктами своих технологий. Искусственный интеллект будущего – это мы сами, просто усовершенствованные, дополненные. Это создаст проблемы немножко другого класса, не те игрушечные проблемы, про которые приятно писать интеллектуальную фантастику, а проблемы совершенно другого уровня, которые на нынешнем уровне развития мы не можем в полной мере постичь.

Александр Соколов. Коллеги, время вопросов подошло к концу. Сейчас очень интересно посмотреть, как поменялось мнение аудитории. Я сейчас запущу то же голосование. Еще раз, пожалуйста, дорогие зрители, проголосуйте: когда, по-вашему, будет создана система искусственного интеллекта, равная человеческому интеллекту?

- скоро;

- в обозримом будущем;

- в далеком будущем;

- никогда:

- уже создана.

Пожалуйста, перейдите по ссылке, проголосуйте еще раз. А пока зрители голосуют, я хочу попросить Татьяну подвести итог сегодняшней дискуссии. Что вы для себя вынесли? Изменилось ли ваше мнение?

Татьяна Шаврина. Тут не стоит вопрос о необходимости прекращения нашей деятельности. Методология в любом случае нам нужна. Методология должна разрабатываться, должна быть максимально строгой и максимально объективной. Чтобы делать строгую методологию, нам надо задавать больше вопросов, связанных со смежными областями: нейронаукой, эволюционной психологией, задачами оптимизации. Надо ставить больше экспериментов с новыми мощностями. В любом случае, мы больше узнаем про себя. Мне кажется, что это очень здорово.

Александр Соколов. Спасибо, Татьяна. Сергей, теперь прошу вас подвести итог дискуссии. А ваше мнение изменилось хотя бы отчасти? Что-то полезное вы узнали сегодня?

Сергей Марков. Да. Я хотел бы поблагодарить Татьяну за очень продуктивную и конструктивную дискуссию. Конечно, мы меняемся. Обсуждая такие вопросы с интеллектуальным оппонентом, ты всегда узнаешь что-то новое и в какой-то мере корректируешь свою позицию. Она вряд ли поменялась радикально. Но я думаю, что разница между нашими позициями не так велика, как может показаться со стороны. В любом случае это было очень полезно и в какой-то мере будет оказывать влияние на мою дальнейшую работу.

Александр Соколов. Наши зрители еще голосуют. Я пока попрошу участников сегодняшних дебатов выбрать авторов лучших вопросов. У меня две книжки: «Человеческие сети» издательства «Корпус» и «Как быть человеком в эпоху машин». Я попрошу сначала Сергея, а потом Татьяну выбрать авторов. Сейчас я перечислю, какие были вопросы: про творческие способности и генератор случайных чисел; про то, куда смотреть разработчику, который хочет работать с человеческой речью; про автоматизацию управления АЭС; про внедрение эмоций для комфорта работы с ИИ; про идеи Марвина Ли Минского; про три закона робототехники для могучих роботов в далеком будущем. Сергей, ваш выбор.

Сергей Марков. Вопрос про Марвина Ли Минского мне больше всего понравился. Хотя все вопросы были безусловно интересны. Трудно выбирать.

Александр Соколов. Книга «Человеческие сети» уходит Александру Багме. Татьяна, ваш выбор.

Татьяна Шаврина. Жалко, что мы не можем искусственному интеллекту тоже ничего дать, он вопросы тоже задавал.

Александр Соколов. Почему не можете? Сергей является разработчиком.

Сергей Марков. Я не открою большого секрета, если скажу, что Татьяна тоже является одним из разработчиков этой системы, только со стороны своего подразделения. Боюсь, нам придется книжку делить пополам.

Александр Соколов. Загрузить текст этой книги, присовокупить к базе текстов.

Татьяна Шаврина. Оцифруем и загрузим. Я думаю, что Сергей так или иначе получит книгу, потому что он спикер. Давайте отдадим вопросу про искусство.

Александр Соколов. Этот вопрос задавал «Пирожок с ковидлом». Наш постоянный зритель получает книгу «Как быть человеком в эпоху машин». Сейчас я попрошу коллег посмотреть результаты голосований и сравнить, как голосовали зрители в начале и в конце. Сначала большинство проголосовало за вариант «в обозримом будущем», на втором месте вариант «в далеком будущем». Интересно получается, что в ходе дебатов часть голосовавших за обозримое будущее проголосовали за далекое будущее.

Источник: https://www.youtube.com/watch?v=sC–NGQxToM

Татьяна, ваша скептическая позиция убедила некую часть зрителей стать более осторожными в своих оценках. Это здорово. Мы в очередной раз видим, как меняется мнение зрителей в результате нашей работы. Я благодарю вас, дорогие друзья, благодарю Сергея, благодарю Татьяну. Сергей тоже без приза не останется. Замечательная левитирующая пирамидка от проекта @levilogo.ru отправится к Сергею. Татьяна получает замечательного пингвинопитека-мыслителя от Павла Красного и замечательные деревянные подставки для смартфонов от проекта gen.ru.

Участникам дебатов я хочу сказать, что у меня есть мечта, чтобы мы через несколько лет провели дебаты, в которых один из участников был бы системой искусственного интеллекта. Вдруг это получится. По крайней мере, чтобы искусственный интеллект был модератором, который следил бы за тем, чтобы дискуссия шла по правилам корректной научной дискуссии, как принято на форуме «Ученые против мифов». Призом бы в этих дебатах была бы книга Сергея Маркова, которую, я надеюсь, он напишет и издаст очень скоро. Спасибо.

“Ах, обмануть меня нетрудно! Я сам обманываться рад!» Поэт сказал это о любви, но любовь бывает разной. Например, любовь к инопланетянам.

Станислав Дробышевский — Мифы о мозге. Часть 3.

Если посмотреть на Homo rudolfensis, который жил 2,2 млн лет назад, у него было 800 г мозга, у другого индивида спустя 400 тыс. лет - 500 г мозга. Скорее всего, это рекордсмен, которого описали как Homo microcranous - «человек малоголовый». У самых первых Homo с...

Станислав Дробышевский: «Мифы о мозге».

Наши мозги всегда привлекают наше внимание, потому что мы своими же мозгами об этом и думаем. Поскольку мы думаем сами о себе, то нам многое кажется очень сильно искаженным и не таким, каким оно является на самом деле. Мы многое о себе возомнили. Есть набор...

Станислав Дробышевский: «Мифы о мозге». Часть 2.

По сути это прохождение зеркального теста - когда кто-то узнает себя в зеркале. Этот тест проходят даже не все люди и человекообразные обезьяны с первого раза. Собаки, дельфины, вороны еще более или менее проходят этот тест. А большинство животных (99,9%) - не...

Станислав Дробышевский: «Мифы о мозге». Часть 3.

Слушатель. Если эволюция предполагает только генетическую рулетку, и приспосабливаемость с уже заложенным материалом, влияют ли факторы среды на потомство непосредственно, а не опосредованно, негативно или позитивно? Например, алкоголь или наркотики на генетику...

Станислав Дробышевский: «Мифы о мозге». Часть 4.

Слушатель. Тупеть или нет - это индивидуальный выбор индивида. Станислав Дробышевский. Именно. Большая часть людей делает этот выбор не в лучшую сторону. Я даже по себе знаю. Как карантин начался, я два месяца ничего полезного не делал, кроме лекций. 99% людей, как...

Лишнее в человеке. Дробышевский. Человек разумный

У человека и у шимпанзе количество волос будет примерно сопоставимо. Избыточный рост волос на теле - это результат новых повторных мутаций. Может, еще максимум жгутик, чтобы шевелиться, но это уже роскошь. Аппендикс нужен для формирования иммунитета. От каждой...

Лишнее в человеке. Дробышевский. Человек разумный. Часть 2.

Подобное можно сказать и о гипофизе. Когда-то это была жаберная железа, первый глоточный карман. В итоге гипофиз оказался частью мозга, выделяющей гормоны и регулирующей кучу других желез. Исходно это была одна общая внешняя система, а теперь он отвечает за выделение...

Станислав Дробышевский: Эволюция мозга.

Сегодня речь пойдёт об эволюции мозга человека. Понятно, что мозг человека возник не вдруг и не сразу - было много разных причин его современного состояния. Первое, что стоит сказать - откуда мы что-то знаем. На самом деле знаний про мозг у нас не так много по той...

Станислав Дробышевский: Эволюция мозга. Часть 2.

Поэтому может быть лучше использовать относительный объём мозга, то есть массу мозга в процентах к массе тела. Тут есть такая сложность, что для современных посчитать не проблема, а для ископаемых проблема, потому что у нас есть какие-то остатки, чаще всего...

Станислав Дробышевский: Эволюция мозга. Часть 3.

Мутации, понижающие размеры челюстного аппарата, довольно вероятны. Поломать какой-нибудь ген не так сложно. Мутации тут же возникают. Они возникали и раньше, но раньше они удалялись отбором, а теперь не удаляются - челюсти уменьшаются, что мы наглядно видим на черепе...